在网络安全领域中,人工智能应用设计来对抗作为战略威胁的虚假信息

管理学院副教授罗米拉·赛义德和法国巴黎大学的斯特文森·加格农,以及一组研究人员,正在研究使用人工智能(AI)来打击虚假信息,将其作为网络安全领域的战略威胁。

我们的团队专注于一种非常具体的虚假信息:针对政治家治理角色的虚假指控。该项目得到了以人为中心的网络安全伙伴关系(HC2P)(2.5万加元)和qu忧郁研究基金会(17.5万加元)的资助。

虚假信息,无论是文字,视频还是图像形式,都可以针对公共部门项目,目的是玷污其他运作良好的政府倡议。这些威胁包括虚假的利益冲突、裙带关系、贿赂和腐败。这些说法依赖于假设和/或捏造的事实,两者都很难在合理怀疑的情况下得到证实。对这种虚假信息的管理不善可能会在数年内损害民主,并有可能使我们的机构和领导人失去无法恢复的信任。它可能导致项目或计划被取消,从而剥夺公民的服务,阻碍国家发展。它还可能导致决策过程被伪造,特别是在国会和议会听证会或其他干预委员会上被提及时。因此,我们的团队专注于设计一个正式的模型来监测和检测错误信息,并指导政治虚假信息领域的决策。

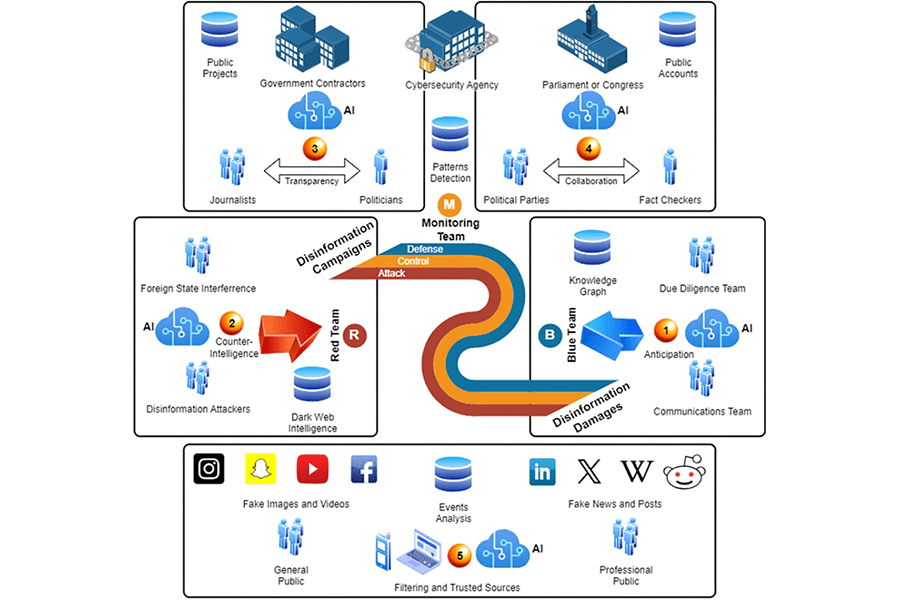

该图显示了参与者、信息和所涉及的技术的广泛范围。我们确定了五个方面:(1)打击虚假信息损害的蓝队;(二)红队造谣;(3)政府项目定向;(4)受到攻击影响的议会;(五)传播虚假信息的公众。网络安全机构和监控团队处于“中间”。该团队正从“整个活动”的角度来监控虚假信息,以提供至少五个主要功能:(1)预测假新闻链中的“下一个事件”,以帮助蓝队更有战略地进行战斗;(2)关于暗网行动者的反情报,以威慑和解除武装;(3)通过将公共项目信息与政治家的行为和正式新闻联系起来,提高透明度;(4)政党与其事实核查员网络之间的合作,确保在议会中不传播虚假信息或用于决策;(5)过滤和可信来源系统,以支持最终用户,无论是普通公众还是专业人士。

截至2024年,我们的团队正在收集几起腐败案件的案例研究数据,其中一些指控被证明是真的,而另一些则是假的。该团队还开发了新的虚假信息本体(正式的机器可读概念模型)和知识图(KGs;一个庞大的逻辑关系网络,包括决策规则)来帮助建立虚假信息活动和攻击模式的模型,然后将其集成到图形增强的大型语言模型(llm)中。最后,我们与政治传播专家合作开发了一套用例,他们将帮助确定如何使用人工智能,特别是会计师事务所和法学硕士,来克服他们工作中的虚假信息影响,并确保更快、更准确地进行尽职调查,以解决针对政客的腐败指控。

信息系统副教授